特斯拉最近又出大新闻了。才内部邮件宣布达成L2级自动驾驶,这次彻底“纯视觉”了。

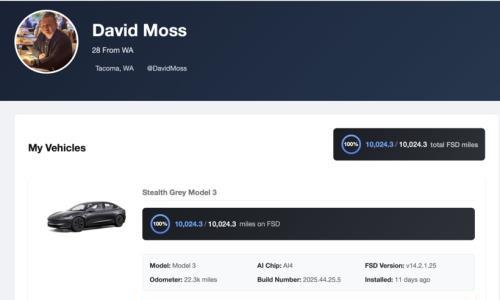

这次是美国时间7月10日,特斯拉FSD Beta V9.0终于在美国向用户推送。相比起上一个版本,V9.0做了FSD有史以来最大的一次更新。彻底抛弃了雷达的使用。而且,特斯拉征召了2000名车主内测,报名踊跃。不过,BUG很快就出来了。

这不,一位叫Giacaglia的网友看了一下特斯拉车主们发的视频,马上就收集了FSD 9.0 beta的11个失误瞬间。从各个动图来看,很明显现在的系统还是只能算是驾驶辅助,如果脱手或者离开人的监控,还是会出事情。这次可以看到的BUG有:

场景一:自动转弯之后径直向道路中央的绿化带撞了过去。

场景二:无法识别路中单轨道路。

场景三:闯公交车专用道。

场景四:在单行车道上逆行。

场景五:一直转换车道。路口右转时,无法判断使用哪个车道。

场景六:汽车压实线并线;急需换道时,因为后方车辆逼近,错过时机,只能下个路口见了。

场景七:自动并线超车之后发现道路划线,还要强行压线并道。

场景八:左转时提前换道。

场景九:左转时,差点进入对向路边停车位。

场景十:汽车穿过几条车道后才能左转。

场景十一:在一个只有停车标志的地方,看到两个停车标志。

“作为一个做Deep Learning方向的人表示,用神经网络的车我是肯定不敢坐的……”“是的,做ML(Machine Learning)的看现在的自动驾驶,堪比医生遇到挂科的同学给自己做手术。”“强行让机器来学人(纯靠视觉)本就是错误的发展方向,机器有自己的优势(可以自由加装雷达等设备进行辅助)而不利用,就是典型的教条主义、本本主义。”……

这都是很专业的质疑,那么,特斯拉是不是点错科技树?这个问题虽然见仁见智,但是从主流的CV(Computer Vision)+雷达路线来说,特斯拉有点像“西毒”欧阳锋了,为了降低成本,纯视觉一条道走到黑,“虽百死而不悔”的精神虽然有了,但是,那都是消费者的命啊……

为什么纯视觉?

如果特斯拉很老实地讲自己是驾驶辅助也就罢了,坏就坏在从一开始马斯克喜欢“吹”自动驾驶,直到吹破了以后在内部邮件中承认是L2级驾驶辅助。但是,现在马斯克给吹得成为一种神话,这种造神运动让马斯克骑上虎背下不来了。

而且,国内外有太多“特吹”,包括大众集团CEO赫伯特*迪斯博士。当然,迪斯博士吹特斯拉,是为了麻痹敌人,那是另外一回事。

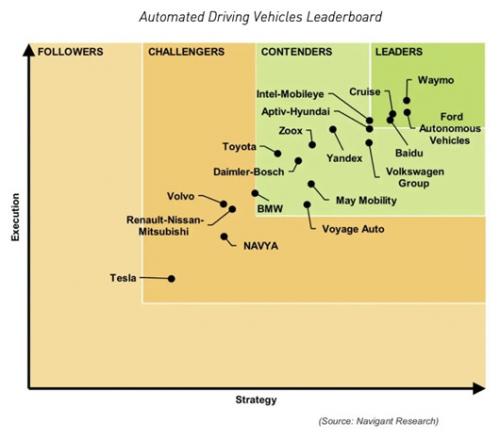

且不说特斯拉多年排名垫底的自动驾驶功力,已经让多少人命丧黄泉,单说特斯拉靠“纯视觉”方案,说能达到全自动驾驶L4~L5级别,这就让人匪夷所思了。

苏黎世联邦理工学院(ETH Zurich)教授Marc Pollefeys则认为特斯拉不太可能放弃完全自动驾驶近在咫尺的说法,“很多人已经为此买单(特斯拉的FSD套餐),所以他们必须保持希望,”他说,“他们被困在那个故事里。”故事已经成为一种神话。

那么,为什么特斯拉取消雷达使用纯视觉?特斯拉多次强调过,摄像头数据和雷达数据在做融合的时候比较困难,当摄像头数据与雷达数据有冲突时,系统反而会更加难以抉择。

所以,马斯克也表示过,与其让二者互相扯后腿,不如只选一个并把它做到极致。而且,在他看来,特斯拉的深度学习系统已经比毫米波雷达强100倍,现在的毫米波雷达已经开始拖后腿了。

而在今年的CVPR(计算视觉与模式识别大会)上,特斯拉首席AI科学家安乔*卡帕西(Andrej Karpathy)还讲了特斯拉如此“执拗”的原因。不过,对于走上歧路的特斯拉,我们还是奉劝要保持冷静。

为什么呢?道理其实很简单,人在开车,虽然是以视觉为主,但是其他的感官都是一体作用的,并非无用。比如听觉,身体的触觉,甚至是意识的直觉等。“事实上,人类开车的时候,是一种近乎无意识的感知,他就能够预测下一步应该怎么办,从而规避事故。”这是奇瑞科技有限公司总经理李中兵在世界人工智能大会的一场论坛上所讲的。而在这点,特斯拉有点过于执着在视觉上了。

通用视觉系统和神经网络

那么,这次的CVPR上,特斯拉的安乔*卡帕西(Andrej Karpathy)详细介绍的基于深度学习开发的自动驾驶系统,也就是全视觉的好处是什么?

特斯拉的底气,是采用了“通用视觉系统”和“神经网络”两种黑科技。当然,Karpathy强调,基于视觉的自动驾驶,在技术角度更难实现,因为它要求神经网络仅仅基于视频输入就能达到超强性能的输出。“不过,一旦取得了突破,就能获得通用视觉系统,方便部署在地球的任何地方。”

“我们抛弃了毫米波雷达,车辆只靠视觉来行驶。”Karpathy认为,有了通用视觉系统,车辆就不再需要什么补充信息了。特斯拉始终认为,收集环境信息是一回事,利用环境信息又是另一回事。而且,传感器的种类和数量越多,互相之间的协调与整合就越难做,最终效果恐怕只是1+1<2,得不偿失。

这次特斯拉发布的FSD Beta V9.0,从技术上来说,新算法调用所有用于自动驾驶的8个摄像头,修复跨镜头畸变、时域差,拼接成环视视觉,再对周围环境进行实时的3D建模。也就是特斯拉所谓的“鸟瞰图视觉”。

具体来说,就是特斯拉将2D视图转化为模拟激光雷达数据,然后再用(激光雷达)算法处理这些数据,得到比之前好非常多的视觉测距精度。你不觉得奇怪么,既然还是得用激光雷达算法,为什么不用激光雷达呢?

按照特斯拉的说法,其自动驾驶系统是基于神经网络的特征识别、预判和规控,对于道路环境项目进行学习,比如交通路牌的含义到底是什么,需要通过很多场景素材训练系统,训练得越多系统能处理的场景越多。通过几百万车主积累的大数据,表现出来的能力就是,特斯拉可以轻松做到目前城市道路的自主驾驶。

实际上,马斯克一直都希望将特斯拉的制造成本压到最低。从成本上来说,目前特斯拉Model 3的自动驾驶摄像头成本只需要65美元。而激光雷达的成本,还基本上在1000美元以上级别。要知道,2018年的时候,Velodyne的64线激光雷达HDL-64售价可是高达7.5万美元的。

支撑特斯拉车价一降再降的当然是成本的控制。但是,马斯克和特斯拉还是过于迷信软件和AI的力量了。对于自动驾驶的“长尾问题”,特斯拉认为靠AI和超级计算机能解决,这都是有问题的。就算完成了99%,最后的1%依然是不可跨越的鸿沟。

此外,已经有外媒认为,美国本土的传统车企通用汽车将在2021年超越特斯拉,原因就在于特斯拉在自动驾驶方面已经落后,特别是又在“纯视觉”的路线上一条道走到黑。

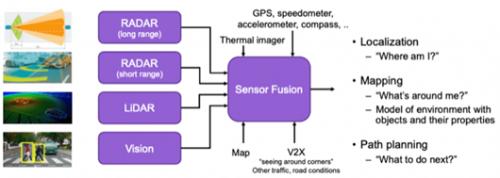

传感器融合才是未来

就纯视觉的局限来说,有业内人士认为,在一些极端的场景中是无法满足对于感知探测能力的KPI指标的。比如一些复杂的天气情况,如大雨、大雾、沙尘、强光、夜晚,这对于视觉和激光雷达都是非常恶劣的场景,难以用一种传感器应对。主要体现在几个大的方面:

1)天气环境因素造成的视觉传感器致盲(如逆光炫目、沙尘暴遮挡等);

2)小目标物体在中低分辨率视觉感知系统中,可能造成目标晚识别(如减速带、小动物、锥桶等);

3)异形目标由于未经训练可能造成无法匹配,被漏识别(道路落石、前车掉落轮胎等);

4)视觉传感器本身的识别要理要求,对于视觉识别的高算力需求等。

就算一些自动驾驶测试或比较成熟厂商,在智能驾驶中也多次发生撞车事故,为传感器系统的失效付出惨痛代价。所以,传感器融合是构建稳定感知系统的必要条件。毕竟,视觉感知能力有局限,必须结合毫米波雷达或激光雷达做优势互补才能实现。

回头来说,这次特斯拉的内测BUG里面,但凡有一个场景没有人类驾驶员眼明手快接手的话,就会演变成为交通事故。这能让人放心吗?特斯拉的车主们也忒心大了。

此外,我们知道,摄像头如何感知深度只是自动驾驶问题的一部分。特斯拉依靠的最先进的机器学习只是识别模式,这意味着它会在新情况下挣扎。一挣扎,就会产生误判。

与人类司机不同的是,如果系统没有遇到场景,它就无法推理该做什么。“任何AI系统都不了解实际发生的事情,”研究自动驾驶汽车计算机视觉的康奈尔大学副教授克里安*温伯格(Kilian Weinberger)如此表示。

还有一点是,虽说,FSD 9.0给智能辅助驾驶系统是创造了更广阔的应用场景,但是,在L2级别的驾驶辅助系统(而不是自动驾驶系统)这个前提下,这些功能多少仍显得有些鸡肋,因为驾驶过程中根本无法脱手。而且,人类驾驶员不仅需要手握方向盘,还需要在城市道路上与车载电脑系统较劲,增加了额外负担和心理压力。

FSD BETA V9.0的这些内测BUG会在实际道路上反复出现,毫无疑问这为城市交通也制造了更多的隐患。不过,这套系统能不能用在更加复杂的中国的开放道路上?公社的小伙伴中还是有对特斯拉超有信心的,“大家都没开过,怎么知道行不行呢?”是啊,是骡子是马,特斯拉总会拉出来遛遛。

扫一扫关注微信

扫一扫关注微信