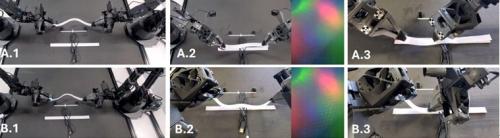

在日常生活中,从桌上拿起一杯咖啡是一件再简单不过的事。诸如视觉(判断杯子距离)与触觉等多重感官输入会实时融合。然而,要在人工智能(AI)中重现这一过程却并非易事。

据外媒报道,由香港大学(University of Hong Kong)和日本东北大学(Tohoku University)组成的国际研究团队开创了一种新方案,即将视觉与触觉信息融合以用于操控机械臂,并实现环境自适应响应。相较于传统基于视觉信息的方法,这一方案显著提升了任务成功率。这些颇有前景的成果标志着多模态物理AI领域取得重大突破。该团队突破性成果的相关细节发表在《IEEE机器人与自动化快报(IEEE Robotics and Automation Letters)》期刊上。

扫一扫关注微信

扫一扫关注微信